A empresa afirma publicamente que sua inteligência artificial lida bem com a remoção de conteúdo nocivo, mas documentos internos indicam que o algoritmo é ineficaz.

Salve esta história

Salve esta história

Publicamente o Facebook afirma excluir mais de 90 % das declarações de ódio em sua plataforma, mas em documentos internos privados a empresa diz que esse indicador é de apenas 3-5 %. O Facebook quer que acreditemos que quase toda a retórica odiosa está se afastando, enquanto quase tudo permanece na plataforma.

Essa hipocrisia obscena foi revelada no cenário de inúmeras queixas com base em milhares de páginas de vazamento de documentos internos, que o funcionário do Facebook, que se tornou uma exposição, torno u-se Francis Haugen e sua equipe jurídica submetida aos valores mobiliários e trocas dos EUA no início de este mês. Embora a atenção do público a esses vazamentos tenha sido focada no efeito do Instagram na saúde dos adolescentes (que dificilmente pode ser chamado de arma de fumantes) e no papel das notícias alimentadas por algoritmo no aumento da desinformação (que dificilmente pode ser chamada de revelação) , a incapacidade absoluta do Facebook de limitar a linguagem do ódio e um simples truque de trapaça, no qual ela constantemente confiava para esconder essa incapacidade, é chocante. Ele mostra o quanto o Facebook conta com inteligência artificial para moderação de conteúdo, quão ineficaz é essa inteligência artificial e quanto é necessário forçar o Facebook a admitir sua culpa.

Opinião com fio

Sobre o site

Noah Dzhansiracuse (@profnoahgian) – Professor Associado de Matemática e Ciência dos Dados da Universidade de Bentley e o autor do livro “Como os algoritmos criam e impedem notícias falsas: Estudo da influência das redes sociais, Fakes Deep, Gp t-3 e muito mais.

Tomando o testemunho do Senado dos EUA em outubro de 2020, Mark Zuckerberg se referiu a relatórios sobre a transparência da empresa, que, segundo ele, mostram que “Penso, penso, cerca de 94 % das declarações odiosas que finalmente excluímos. “Alguns meses depois, testemunhando a Câmara dos Deputados, Tsuckerberg respondeu da mesma forma perguntas sobre incitar o ódio, citando um relatório sobre transparência: “Também excluímos cerca de 12 milhões de unidades de conteúdo em grupos por violação de nossa política de ódio, 87 % dos quais Somos encontrados em ordem proativa. “Em quase todos os relatórios trimestrais sobre a transparência, o Facebook declara a porcentagem de moderação da língua inimiga nos anos 80 e 90, como esses. No entanto, o documento vazou para a rede de março de 2021 diz: “Podemos parar apenas 3-5 % do ódio … no Facebook”.

O Facebook foi realmente pego em uma mentira descarada? Sim e não. Tecnicamente, ambos os números estão corretos – eles apenas medem coisas diferentes. A métrica que realmente importa é aquela que o Facebook vem escondendo. A métrica que o Facebook reporta publicamente não importa. É como se toda vez que um policial parasse você e perguntasse o quão rápido você estava dirigindo, você sempre ignorasse a pergunta e, em vez disso, se gabasse da quilometragem do seu carro.

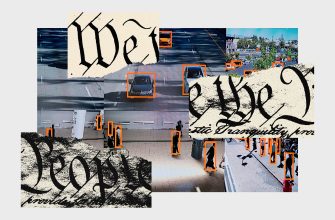

Existem duas maneiras de sinalizar o discurso de ódio para revisão e possível remoção. Os usuários podem denunciá-lo manualmente e algoritmos de inteligência artificial podem tentar detectá-lo automaticamente. A detecção algorítmica é importante não apenas porque é mais eficiente, mas também porque pode ser feita antecipadamente, antes que os usuários denunciem o discurso de ódio.

É como se toda vez que um policial parasse você e perguntasse o quão rápido você estava dirigindo, você sempre ignorasse a pergunta e, em vez disso, se gabasse da quilometragem do seu carro.

O número de 94 por cento que o Facebook declara publicamente é a sua “taxa proativa”, que é o número de materiais de discurso de ódio removidos que a inteligência artificial do Facebook detectou proativamente, dividido pelo número total de materiais de discurso de ódio removidos. O Facebook provavelmente quer que você pense que este número mede quanto o discurso de ódio é removido antes que tenha a oportunidade de causar danos, mas na realidade ele apenas mede o tamanho do papel que os algoritmos desempenham na detecção de discurso de ódio na plataforma.

O que importa para a sociedade é a quantidade de discurso de ódio que não é retirado da plataforma. A melhor forma de captar isto é dividir o número de remoções de discurso de ódio pelo número total de incidentes de discurso de ódio. Esta “taxa de remoção” mede quanto discurso de ódio no Facebook é realmente removido, e é o número que o Facebook tentou manter em segredo.

Graças a Haugen, finalmente sabemos o número de sites excluídos, e isso é deprimente. Mais de 95% do discurso de ódio compartilhado no Facebook permanece no Facebook, de acordo com documentos internos. Zuckerberg vangloriou-se ao Congresso de que o Facebook removeu 12 milhões de discursos de ódio em grupos, mas com base em informações vazadas, sabemos agora que cerca de 250 milhões de discursos de ódio foram provavelmente deixados para trás. É surpreendente e mostra quão pouco progresso foi feito desde os primeiros dias dos fóruns não regulamentados na Internet – apesar dos investimentos significativos que o Facebook fez em inteligência artificial para moderação de conteúdo ao longo dos anos.

Mais popular

A ciência

Uma bomba-relógio demográfica está prestes a atingir a indústria da carne bovina.

Matt Reynolds

Negócios

Dentro do complexo supe r-secreto Mark Zuckerberg no Havaí

Gatrine Skrimjor

Engrenagem

Primeira olhada em Matic, um aspirador de robô processado

Adrienne co

Negócios

Novas declarações de Elon Mask sobre a morte de um macaco estimulam novos requisitos para a investigação da SEC

Dhruv Mehrotra

Infelizmente, a denúncia de que a equipe jurídica de Haugen apresentou à Comissão de Valores Mobiliários confundiu o caso, destacando com BOLD: “Os documentos do Facebook confirmam que as declarações do Facebook eram falsas”. Isso por si só é falso: o Facebook não mentiu tecnicamente ou “distorcido” a verdade, conforme declarado na denúncia, mas ela repetida e irrefutavelmente enganou o público sobre qual poço incitar o ódio é sua plataforma e quão terrivelmente a empresa sabe como restringir dela.

Não se surpreenda que a equipe de defesa do Facebook ocupará a desleixo da equipe de Haugen. Mas deixe você não enganar nenhuma tentativa de desacreditar as conclusões da exposição. O ponto principal é que o Facebook sabe há muitos anos que não lida com o controle da linguagem do ódio em sua plataforma e, para escond ê-lo dos investidores e do público, o Facebook vende um indicador sem sentido de proatividade para nos desviar de um indicador significativo e cuidadosamente protegido do número de remoção.

Outro indicador de que o Facebook às vezes se rega é a “prevalência” da linguagem do ódio. A pedido de comentar este artigo, o representante do Facebook escreveu por e-mail que “a prevalência do idioma inimigo no Facebook agora é 0, 05 % do conteúdo visível e diminuiu quase 50 % nos últimos três trimestres”. A expectativa realmente dá uma idéia de quanta linguagem de ódio está na plataforma, mas ela ainda desenha um retrato enganosamente otimista. A disseminação do idioma do ódio é tão desigual que por trás de uma porcentagem tão difícil é a alta prevalência da linguagem de ódio encontrada em comunidades específicas e que muitos usuários individuais enfrentam. Além disso, se você vê no conteúdo do Facebook que não contém ódio, isso não o torna menos prejudicial – e é isso que implica dependência da prevalência.

À medida que a atenção do público passa da identificação dos vícios das redes sociais para a busca de maneiras de elimin á-las, duas conclusões importantes podem ser tiradas.

Em primeiro lugar, Zuckerberg repetiu há muito tempo a afirmação de que a melhoria da inteligência artificial se tornará a chave para combater o conteúdo nocivo da empresa. Ele falou sobre isso após as eleições de 2016, quando a campanha de desinformação realizada pela Rússia se desenrolou na plataforma. Ele disse isso em 2017 no vídeo do Facebook Live, quando fritou a carne na churrasqueira em seu quintal: “Estou especialmente configurado em relação à IA, pessoas que são céticas e tentam escalar esses cenários, simplesmente não entendo isso “. É significativo que o CEO do Facebook compartilha detalhes mais detalhados sobre como ele fuma o peito da vaca, que ele esfaqueou (225 graus por oito horas, entregando a cada duas horas) do que sobre a inteligência artificial de sua empresa, mas aqui é o cenário do fim do mundo, que ele pode entender: no quintal 2021, e a inteligência artificial Facebook ainda pegou apenas a pequena parte da linguagem do ódio na plataforma.