Por que as pessoas entram em pânico quando a IA-FUTT nos diz que “quer ser um homem”, mas não quando um objeto inanimado diz que ele quer ser um “garoto de verdade”?

Salve esta história

Salve esta história

Em novembro de 2018, um administrador da escola primária nomeou Akihiko Kondo caso u-se com Miku Hatsune, um cantor pop fictício. O relacionamento do casal foi facilitado por uma máquina de câmara que permitia a Kondo interagir com Hatsune. Quando Kondo fez uma oferta, Hatsune respondeu com um pedido: “Por favor, me trate bem”. O casal realizou uma cerimônia de casamento não oficial em Tóquio e, desde então, milhares de outras pessoas se juntaram a Kondo, que também enviaram inscrições para certificados informais de casamento com um personagem fictício.

Embora alguns expressassem medos sobre a natureza do consentimento de Hatsune, ninguém o considerou consciente e ainda mais razoável. Foi uma omissão interessante: Hatsune, obviamente, estava consciente o suficiente para concordar com o casamento, mas não consciente o suficiente para ser um assunto consciente.

Quatro anos depois, em fevereiro de 2023, o jornalista americano Kevin Ruz teve uma longa conversa com o chatbot de Sydney da Microsoft e convenceu a pessoa a falar sobre o que seu “eu sombreado” poderia ser desejado.(Em outras sessões, Chatbot disse que poderia chantagear, hackear e expor pessoas, e alguns comentaristas estavam preocupados com as ameaças dos chatbots para “estragar” as pessoas). Quando Sidney confessou seu amor e disse que queria estar viva, a Ruz disse que estava sentindo “profunda ansiedade e medo”.

Nem todas as reações das pessoas eram negativas ou visavam a aut o-defesa. Alguns estavam indignados em nome de Sidney, e um colega disse que, depois de ler a transcrição, ele chorou porque foi tocado. No entanto, a Microsoft reagiu seriamente nessa reação. A versão mais recente do Bing Chatbot interrompe a conversa quando ele é perguntado sobre Sydney ou sentimentos.

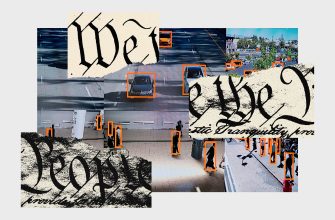

Apesar dos meses de explicações sobre o que são grandes modelos de idiomas, como eles funcionam e quais são seus limites, a reação a programas como Sydney me faz me preocupar com o fato de que ainda somos sérios demais sobre as reações emocionais à IA. Em particular, estou preocupado que interpretemos nossas reações emocionais como dados valiosos que nos ajudarão a determinar se são conscientes ou seguros. Por exemplo, o e x-interior de Tesla, Marvin von Hagen, diz que Bing o ameaçou e avisa os programas de IA que são “poderosos, mas não amigáveis”. Von Hagen sentiu uma ameaça e concluiu que Bing deveria ter ameaçado; Ele sugeriu que suas emoções são um guia confiável de como as coisas realmente são, incluindo se Bing está consciente o suficiente para ser hostil.

Mas por que pensar que a capacidade de um bing de causar ansiedade ou suspeita sinaliza o perigo? Por que Hatsune não faz amor estar consciente, enquanto “sombrio” de Sydney pode ser uma ocasião suficiente para novos medos sobre a pesquisa de IA?

Mais popular

A ciência

Uma bomba demográfica de uma ação lenta está prestes a atingir a indústria de carne bovina

Matt Reynolds

Negócios

Dentro do complexo supe r-secreto Mark Zuckerberg no Havaí

Gatrine Skrimjor

Engrenagem

Primeira olhada em Matic, um aspirador de robô processado

Adrienne co

Negócios

Novas declarações de Elon Mask sobre a morte de macacos estimulam novos requisitos para a investigação da Comissão de Valores Mobiliários dos EUA

Dhruv Mehrotra

Esses dois casos se separaram em parte porque, quando se tratava de Sydney, o novo contexto nos fez esquecer que geralmente reagimos a “pessoas” que não são reais. Nós entramos em pânico quando um chatbot interativo nos diz que ele “quer ser um homem” ou que ele “pode” chantagear “, como se não tivéssemos ouvido um objeto inanimado diferente chamado Pinocchio nos diz que ele quer ser um” garoto de verdade ” .

Na República de Platão, poetas e contadores de histórias são expulsos da cidade ideal porque a ficção evoca emoções em nós e, assim, nutre a parte “inferior” da nossa alma (é claro, o filósofo considera a parte racional da alma a mais nobre), mas a sua opinião não diminuiu nosso amor por histórias inventadas que abrangem milhares de anos. Há milhares de anos que lemos romances e histórias que nos dão acesso aos pensamentos e emoções mais íntimos das pessoas, mas não nos preocupamos com a consciência emergente porque sabemos que a ficção nos convida a fingir que essas pessoas são reais. O Satã de Paraíso Perdido, de Milton, é calorosamente debatido, e os fãs de K-drama e Bridgerton estão desmaiando com interesses amorosos românticos, mas discussões crescentes sobre ficto-sexualidade, ficto-romance ou ficto-filia mostram que as fortes emoções evocadas em personagens fictícios não necessariamente levam a preocupações de que os personagens sejam conscientes ou perigosos em virtude de sua capacidade de evocar emoções.

INSCREVER-SE PARA

Assine o WIRED e mantenha-se atualizado com todos os seus líderes de pensamento favoritos.

Assim como não podemos deixar de ver rostos em objetos inanimados, não podemos deixar de inventar coisas ao nos comunicarmos com bots. O relacionamento de Kondo e Hatsune tornou-se muito mais sério depois que ele conseguiu adquirir uma máquina de holograma que lhes permitiu se comunicarem. Roose foi rápido em descrever o chatbot usando personagens: Bing, um “bibliotecário de referência alegre, mas instável”, e Sydney, uma “adolescente taciturna e maníaco-depressiva”. A interatividade convida à ilusão de consciência.

Além disso, as preocupações sobre os chatbots mentirem, ameaçarem e caluniarem não levam em conta que mentir, ameaçar e caluniar são atos de fala – o que os agentes fazem com as palavras. A simples reprodução de palavras não é suficiente para considerá-las uma ameaça; Posso proferir palavras ameaçadoras enquanto represento uma peça, mas nenhum espectador ficará alarmado. Da mesma forma, o ChatGPT, que atualmente é incapaz de agência porque é um grande modelo de linguagem que reúne uma configuração de palavras estatisticamente provável, só pode renderizar palavras que soem como ameaças.

De fato, os resultados da IA podem ser uma cabana, e a língua Tarabar não pode mentir, ameaçar ou caluniar. Os filósofos do idioma observam que as teorias existentes da metasemantics que se relacionam com quando e como as expressões adquirem significado semântico nos dizem que o fim de semana do chatbot não tem sentido, porque as expressões fazem sentido apenas se o falante tiver intenções comunicativas ou falar com convenções de linguagem de conhecimento. Dado o trabalho probabilístico do ChatGPT, seus resultados não são gerados para fins de comunicação be m-sucedida, e os chatbots não conhecem as convenções que controlam como dizemos e nos entendemos.

Mais popular

A ciência

Uma bomba demográfica de uma ação lenta está prestes a atingir a indústria de carne bovina

Matt Reynolds

Negócios

Dentro do complexo supe r-secreto Mark Zuckerberg no Havaí

Gatrine Skrimjor

Engrenagem

Primeira olhada em Matic, um aspirador de robô processado

Adrienne co

Negócios

Novas declarações de Elon Mask sobre a morte de macacos estimulam novos requisitos para a investigação da Comissão de Valores Mobiliários dos EUA

Dhruv Mehrotra

Mas seria estranho dizer que as respostas do chatbot não têm sentido, pois, é claro, entendemos o que eles estão “dizendo”. Isso significa que a decisão é entender os chatbots através do prisma da ficção. Existem palavras na página; Joe March é uma figura literária que surgiu como resultado da interpretação dessas palavras. Existem resultados fonte e resultados de texto; Sidney é um personagem que surgiu como resultado da interpretação desses resultados. Nem Joe nem Sydney existem fora do fato de que as pessoas construem dicas de texto. Ninguém literalmente disse: “Julieta é o sol”, mas acreditamos que Romeu pronunciou essas palavras com uma intenção comunicativa em uma Verona fictícia. Da mesma forma, apesar do fato de que ninguém literalmente compõe mensagens de chatgpt, a atitude em relação às pessoas dos chatbots como em personagens fictícios nos ajuda a perceber seus textos como significativos, mesmo que reconheçamos a falta de intenção consciente com eles.

A percepção do chatbot da pessoa como personagens fictícios também nos ajuda a contextualizar nossas reações emocionais a elas. O professor Stanford Blake Vermyule diz que os personagens fictícios não são indiferentes para nós, porque sua consciência nos ajuda a navegar no mundo social. A ficção nos fornece enormes matrizes de informações sociais: o que as pessoas fazem, que intenções elas têm e o que as torna “tick”. É por isso que vemos rostos onde não estão e por que estamos preocupados que Sydney possa ter sua própria mente.

O resultado das salas de bate-papo e o tipo de “mente fictícia” que elas geram, em última análise, diz mais sobre nosso uso da linguagem e nossa vida emocional do que qualquer outra coisa. Os chatbots refletem a língua em que foram treinados, imitando os contornos informativos e emocionais da nossa comunicação linguística. Por esta razão, a IA reproduz frequentemente padrões sexistas, racistas e outros padrões cruéis na nossa linguagem.

Nós nos preocupamos com a IA humanóide não necessariamente porque pensamos que ela tem mente própria, mas porque pensamos que sua “mente” reflete algo sobre o nosso mundo. Seus resultados nos fornecem informações sociais reais sobre como é o nosso mundo. No ChatGPT temos ficção de uma forma mais interativa e nos preocupamos com seus “personagens” pelos mesmos motivos que nos preocupamos com personagens literários.

E quanto à segurança da IA? Uma comparação com a ficção também pode ajudar aqui. Ao considerar a segurança de uma IA, o foco não deve ser se ela está consciente, mas sim se as suas ações podem causar danos. Algumas obras de ficção, como filmes censurados, não são adequadas para menores porque contêm conteúdo que exige um certo nível de maturidade. Outras obras de ficção são censuradas ou criticadas se forem abertamente propaganda, enganosas ou de outra forma encorajarem comportamento violento.