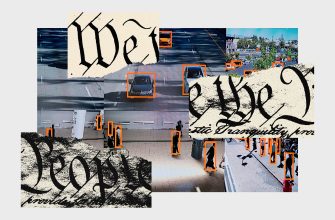

Os dispositivos de espionagem desenvolvidos por empreiteiros de defesa agora são vendidos aos empregadores para identificar organizações trabalhistas. As autoridades regulatórias devem defender a vida privada dos funcionários.

Salve esta história

Salve esta história

Provavelmente é difícil imaginar que você é um objeto de espionagem, mas a espionagem para os funcionários é a próxima linha de IA militar. Os métodos de vigilância, familiares à ditadura autoritária, agora estão sendo lançados para sobreviver aos trabalhadores americanos.

Na última década, apareceram várias dezenas de empresas que oferecem ao empregador uma assinatura de serviços como “exploração de fontes abertas”, “gerenciamento de reputação” e “avaliação da ameaça interna” – ferramentas que eram frequentemente desenvolvidas originalmente por contratados de defesa para inteligência. Com o advento do treinamento profundo e novas fontes de dados nos últimos anos, essas ferramentas se tornaram muito mais complicadas. Com a ajuda deles, seu chefe poderá usar análises avançadas de dados para identificar a organização do trabalho, vazamentos internos e críticos da empresa.

Opinião com fio

Sobre o site

Gabriel Grill é pesquisador da Tecnologia de Ética, Sociedade e Computação da Universidade de Michigan.

Sandwig Christian – Diretor do Centro de Ética, Sociedade e Tecnologia de Computação e Professor da Faculdade de Informações Makluen da Universidade de Michigan.

Não é segredo que as organizações sindicais já são controladas por grandes empresas como a Amazon. Mas a expansão e a normalização das ferramentas para a vigilância dos funcionários não causam comentários especiais, apesar de sua origem ameaçadora. Se eles são tão poderosos quanto eles dizem, ou até mesmo nessa direção, precisamos realizar uma discussão pública sobre a aconselhamento de transferir essas informações para as mãos particulares. A IA da classe militar pretendia combater nossos inimigos nacionais, nominalmente sob o controle de governos democratas eleitos, com garantias que impedem seu uso contra os cidadãos. Devemos ficar perturbados com a idéia de que agora esses mesmos sistemas podem ser amplamente expandidos por qualquer pessoa que possa pagar.

A FiveCast, por exemplo, começou como uma startup antiterrorista que vendeu seus serviços aos militares, mas agora transferiu seus instrumentos para empresas e agências policiais que podem us á-las para coletar e analisar todos os tipos de dados públicos, incluindo suas redes sociais . O FiveCast não conta apenas palavra s-chave, mas possui que sua “segurança comercial” e outras frases podem identificar as redes das pessoas, ler o texto dentro das imagens e até detectar objetos, imagens, logotipos, emoções e conceitos em conteúdo multimídia. Seu instrumento “Gerenciamento de riscos na cadeia de suprimentos” foi projetado para prever falhas futuras no trabalho de empresas, como greves.

As ferramentas de análise de rede projetadas para identificar células terroristas podem ser usadas para determinar os principais organizadores do trabalho, para que os empregadores possam descart á-las ilegalmente na criação do sindicato. O uso padrão dessas ferramentas ao contratar pode incentivar os empregadores a evitar a contratação desses organizadores. E as estratégias da avaliação quantitativa dos riscos desenvolvidos para impedir a nação sobre os ataques terroristas iminentes agora podem ser usados para tomar decisões de investimento, por exemplo, se devem se livrar de empresas e fornecedores, que, de acordo com estimativas, têm alto potencial para organizar o trabalho.

Não está claro se essas ferramentas podem justificar sua agitação. Por exemplo, os métodos de análise de rede são atribuídos à associação, o que significa que você pode ser marcado simplesmente para assistir a uma determinada página ou conta. Esses sistemas também podem ser enganados por conteúdo falso, que é facilmente criado em uma escala com a ajuda de uma nova IA generativa. Algumas empresas oferecem métodos complexos de aprendizado de máquina, como treinamento profundo, para identificar conteúdo, que parece raivosa, que deve sinalizar as queixas que podem levar à unificação no sindicato, embora a detecção de emoções, como mostrado, seja tendencioso e fundado em suposições errôneas.

Mais popular

A ciência

Uma bomba demográfica de uma ação lenta está prestes a atingir a indústria de carne bovina

Matt Reynolds

Negócios

Dentro do complexo supe r-secreto Mark Zuckerberg no Havaí

Gatrine Skrimjor

Engrenagem

Primeira olhada em Matic, um aspirador de robô processado

Adrienne co

Negócios

Novas declarações de Elon Mask sobre a morte de um macaco estimulam novos requisitos para a investigação da SEC

Dhruv Mehrotra

Mas as capacidades desses sistemas crescem rapidamente. As empresas dizem que em breve incluirão novas tecnologias de inteligência artificial de geração em suas ferramentas de observação. Novas funções prometem facilitar o estudo de várias fontes de dados usando dicas, mas o objetivo final parece ser um sistema rotineiro e sem i-automático para monitorar os sindicatos.

Além do mais, esses serviços de assinatura funcionam mesmo quando não funcionam. Não importa se o funcionário rotulado como encrenqueiro está realmente infeliz; os executivos e a segurança da empresa ainda podem tomar medidas sobre a acusação e retaliar injustamente contra ele. Julgamentos agregados vagos sobre as “emoções” dos funcionários ou a imagem pública de uma empresa são atualmente impossíveis de testar quanto à precisão. E a própria presença de tais sistemas poderá ter um efeito inibidor sobre o comportamento legalmente protegido, incluindo a organização do trabalho.

As empresas que prestam estes serviços prosperam na obscuridade e na falta de regulamentação. A proteção de vigilância no local de trabalho é feita do melhor tecido. Os apologistas da indústria dizem que o seu software, vendido para ajudar os empregadores a “compreender o panorama sindical”, não é anti-sindical. Em vez disso, eles se autodenominam vendedores de “monitoramento de conscientização corporativa” e proclamam em voz alta que “todo americano está protegido por leis federais, estaduais e locais para operar em um ambiente seguro”. Obviamente, o fabricante não tem culpa se o comprador usar este software para infringir o direito legalmente protegido de organização ou protesto.

As empresas de vigilância também evitam as críticas, argumentando que apenas utilizam informações publicamente disponíveis, tais como dados de redes sociais e artigos noticiosos. Mesmo que isto seja verdade, os seus argumentos ignoram as consequências do uso da vigilância quotidiana de nível militar contra os cidadãos de uma sociedade livre. As mesmas ferramentas que rastreiam os movimentos dos tanques russos na Ucrânia não devem ser entregues ao seu chefe para espioná-lo. Os fornecedores de software de inteligência parecem esperar que a prática de permitir que os chefes observem profundamente a vida dos seus trabalhadores se torne tão comum que os empregadores o façam o tempo todo, como uma medida proactiva. À medida que as capacidades e os custos da recolha e análise de dados melhoram, enfrentamos um futuro em que qualquer gestor intermédio poderá mobilizar os recursos da sua própria CIA.

Uma indústria de vigilância semelhante é fundamentalmente incompatível com a democracia. As empresas que usam essas ferramentas devem ser forçadas a divulgar publicamente informações sobre seu uso, a fim de garantir a conformidade com as leis existentes. E novas regras são urgentemente necessárias. No ano passado, o Conselho Nacional de Relações Trabalhistas anunciou que se esforçaria para proibir a vigilância “obsessiva” e “ilegal” dos funcionários, o que é um passo importante. Além disso, os funcionários e os sindicatos devem agir nas audiências legislativas sobre a regulamentação futura da IA e o monitoramento dos locais de trabalho. Precisamos de regras específicas que determinam que tipos de uso de IA, fontes de dados e métodos são aceitáveis e sob quais condições elas podem ser aplicadas.

Essas tecnologias já são vendidas e implementadas em todo o mundo e são usadas para observação cruzada. Na melhor das hipóteses, um regulador ativo deve se tornar um líder global no campo da IA responsável e trabalhar na criação de padrões internacionais para tecnologias usadas nos locais de trabalho. Sem esse trabalho, as empresas transnacionais com cadeias de suprimentos globais poderão ignorar ou evitar facilmente a proteção de países específicos.

No final, nossa sociedade pode concluir que a regulamentação não é suficiente: a própria existência desse mercado deve ser ilegal. Podemos dizer que não deve haver lugar onde alguém possa comprar um perfil de IA sobre suas associações, intenções, emoções e pensamentos. Sua vida fora do trabalho deve ser protegida por padrão do empregador.

A opinião da Wired publica artigos de autores de terceiros, representando uma ampla gama de pontos de vista. Leia outras opiniões aqui. Publique sua opinião no site idéias@wired. com.