A situação mostrou que a área precisa de mudanças. Veja por onde começar, de acordo com Googlers atuais e antigos.

Salve esta história

Salve esta história

Banco de dados de IA →

OPINIÃO COM FIO

SOBRE O SITE

Alex Hannah é socióloga e pesquisadora sênior do grupo Ethical AI do Google. Meredith Whittaker é professora pesquisadora do Minderoo na Universidade de Nova York, diretora do Instituto de IA agora na Universidade de Nova York e trabalhadora de longa data do setor de tecnologia que ajudou a liderar a organização trabalhista no Google.

Houve muitos desenvolvimentos este ano, incluindo anúncios ousados de avanços no campo da inteligência artificial. Comentaristas da indústria especularam que o modelo de geração de linguagem GPT-3 pode ter alcançado “inteligência artificial geral”, enquanto outros elogiaram o algoritmo de dobramento de proteínas Alphafold, desenvolvido pela DeepMind, subsidiária da Alphabet, e sua capacidade de “transformar a biologia”. Embora a base para tais afirmações seja mais tênue do que as manchetes, pouco contribuiu para diminuir o entusiasmo numa indústria cujos lucros e prestígio dependem da ascensão da IA.

É neste contexto que o Google demitiu Timnit Gebru, nosso querido amigo e colega, líder na área de inteligência artificial. Ela também é uma das poucas mulheres negras que trabalham na pesquisa de IA e é uma defensora inflexível de trazer mais BIPOC, mulheres e pessoas não ocidentais para o campo. De qualquer forma, ela fez um excelente trabalho para o qual o Google a contratou, incluindo a demonstração de disparidades raciais e de gênero na tecnologia de análise facial e o desenvolvimento de diretrizes de relatórios para conjuntos de dados e modelos de IA. Ironicamente, foi por causa disso, e porque ela era uma defensora veemente daqueles sub-representados na pesquisa de IA, que ela disse que a empresa a demitiu. De acordo com Gebru, depois de exigir que ela e seus colegas retirassem um artigo científico crítico aos sistemas de IA (lucrativos) de grande escala, o Google Research disse à sua equipe que aceitava sua demissão, embora ela não tivesse renunciado.(O Google se recusou a comentar este artigo.)

O aterrorizante apelo do Google com Goebra expõe uma dupla crise nos estudos da IA. Nesta área, a elite domina, principalmente homens brancos e principalmente players industriais grandes controlam e financiam – Microsoft, Facebook, Amazon, IBM e Sim, Google. Com a demissão de Goebra, a política da civilização que conectava jovens esforços para criar as cercas necessárias em torno da IA foi dividida, colocada ao Centro para discussão as perguntas sobre a uniformidade racial dos funcionários da IA e a ineficiência dos programas corporativos de diversidade. Mas essa situação também deixou claro que, por mais sinceras as promessas da empresa como o Google, a pesquisa financiada pela corporação nunca pode ser divorciada das realidades do poder, dos fluxos de renda e capital.

Isso deve se preocupar com todos nós. Com a disseminação da IA em áreas como assistência médica, justiça criminal e educação, pesquisadores e defensores causam sérias preocupações. Esses sistemas tomam decisões que determinam diretamente a vida das pessoas, ao mesmo tempo em que são incorporadas em organizações estruturadas de maneira a fortalecer a história da discriminação racial. Os sistemas de inteligência artificial também concentram o poder nas mãos daqueles que os estão desenvolvendo e usam, ocultando a responsabilidade por cálculos complexos. Os riscos são muito grandes e os incentivos são claramente pervertidos.

A crise atual expõe barreiras estruturais que limitam nossa capacidade de criar proteção eficaz dos sistemas de IA. Isso é especialmente importante, porque os grupos da população, propensos a prejudicar e preconceitos por parte das previsões e decisões da IA, são principalmente pessoas da bipoc, mulheres, minorias religiosas e de gênero, bem como camadas pobres da população – Aqueles que carregam o principal a severidade da discriminação estrutural. Há uma clara separação racial entre aqueles que se beneficiam – empresas e principalmente pesquisadores e desenvolvedores de homens brancos – e aqueles que, provavelmente, serão danificados.

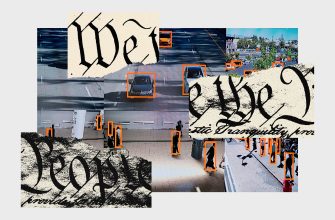

Tomemos, por exemplo, as tecnologias para reconhecer rostos, que, como mostrado, “reconhecem” pessoas com pele escura com menos frequência do que aquelas que têm uma pele mais brilhante. Isso por si só é alarmante. Mas esses “erros” raciais não são o único problema do sistema de reconhecimento de pessoas. Tavana Petty, as questões organizacionais dos dados da organização para vidas negras, observa que esses sistemas em quantidades desproporcionalmente grandes são instalados em áreas e cidades com predominância da população negra, enquanto em cidades onde o uso dos sistemas de reconhecimento de pessoas, branco prevalece .

Mais popular

A ciência

Uma bomba-relógio demográfica está prestes a atingir a indústria da carne.

Matt Reynolds

Negócios

Dentro do complexo ultrassecreto de Mark Zuckerberg no Havaí

Guthrie Scrimgeour

Engrenagem

Primeiro, dê uma olhada no Matic, o aspirador robô redesenhado

Adriane So

Negócios

As novas alegações de Elon Musk sobre a morte de macacos estimulam novas demandas de investigação da SEC

Dhruv Mehrotra

Sem investigação independente e crítica que inclua as opiniões e experiências das pessoas prejudicadas por estas tecnologias, a nossa capacidade de compreender e desafiar as afirmações exageradas feitas pela indústria é significativamente prejudicada. O tratamento dado pela Google a Gebru torna cada vez mais claro onde estão as prioridades da empresa quando o trabalho crítico colide com os seus incentivos comerciais. Isto torna quase impossível responsabilizar os sistemas de IA perante as pessoas mais vulneráveis aos seus danos.

O escrutínio da indústria é ainda mais prejudicado pelos laços estreitos entre as empresas tecnológicas e as instituições académicas supostamente independentes. Investigadores de empresas e do meio académico publicam artigos conjuntos e apresentam-se nas mesmas conferências, e alguns investigadores ocupam até cargos paralelos em empresas de tecnologia e universidades. Isto confunde os limites entre a investigação académica e a investigação empresarial e obscurece os incentivos por detrás de tal trabalho. Isto também significa que ambos os grupos parecem assustadoramente semelhantes – a investigação em IA no meio académico sofre dos mesmos problemas perniciosos de homogeneidade racial e de género que os seus homólogos empresariais. Além disso, os principais departamentos de ciência da computação aceitam enormes quantias de financiamento para pesquisa de grandes tecnologias. Basta olhar para as grandes empresas do tabaco e do petróleo para compreender quão poderosamente as grandes empresas podem influenciar a compreensão do público sobre problemas científicos complexos quando a criação de conhecimento é deixada nas suas mãos.

A demissão de Gebru sugere que esta dinâmica está novamente em ação. Empresas poderosas como a Google têm a capacidade de cooptar, minimizar ou silenciar as críticas aos seus próprios sistemas de inteligência artificial em grande escala – sistemas que estão subjacentes às suas motivações de lucro. Assim, de acordo com um relatório recente da Reuters, os executivos do Google instruíram os pesquisadores a “manter um tom positivo” nos trabalhos que examinam tecnologias e questões sensíveis aos lucros do Google. A demissão de Gebru também destaca os perigos que o resto da sociedade enfrentará se permitirmos que um grupo de pesquisa homogêneo e de elite, composto por pessoas que provavelmente não experimentarão os impactos negativos da IA, conduza e molde a pesquisa na área a partir de um ambiente corporativo. . O punhado de pessoas que beneficiam da ascensão da IA molda a compreensão académica e pública destes sistemas, enquanto aqueles com maior probabilidade de sofrer são excluídos da criação e influência do conhecimento. Estas desigualdades ocorrem ao longo de linhas previsíveis de raça, género e classe.

Mais popular

A ciência

Uma bomba-relógio demográfica está prestes a atingir a indústria da carne.

Matt Reynolds

Negócios

Dentro do complexo ultrassecreto de Mark Zuckerberg no Havaí

Guthrie Scrimgeour

Engrenagem

Primeiro, dê uma olhada no Matic, o aspirador robô redesenhado

Adriane So

Negócios

As novas alegações de Elon Musk sobre a morte de macacos estimulam novas demandas de investigação da SEC

Dhruv Mehrotra

À medida que a poeira começa a baixar devido à demissão de Gebru, surge uma questão: o que fazemos para contrariar estes incentivos e continuar o trabalho crítico sobre IA em solidariedade com as pessoas em maior risco? Temos várias respostas preliminares para esta questão.

Primeiro de tudo, os tecnólogos precisam de um sindicato. Os trabalhadores organizados são uma alavanc a-chave de mudança e responsabilidade, bem como uma das poucas forças que podem suportar grandes empresas. Isso é especialmente relevante no campo da tecnologia, uma vez que muitos funcionários têm demanda e não podem ser facilmente substituídos, o que lhes dá força de trabalho significativa. Tais organizações podem atuar como um fator de restrição contra perseguição e discriminação, além de ser um poder que pode suportar o uso moralmente repreensível das tecnologias. Lembr e-se da luta dos trabalhadores da Amazônia contra as mudanças climáticas ou a resistência dos funcionários do Google ao uso militar da inteligência artificial, que mudaram a política da empresa e demonstraram a força dos trabalhadores de tecnologia aut o-organizados. Para ser eficaz, essa organização deve confiar no anti-radiismo e na solidariedade interclasse, aderir a uma ampla visão de quem é considerado um funcionário técnico e trabalhar para proteger e aumentar o status dos technologistas bipoc é prioritário para todos. Ele também deve usar suas forças coletivas para resistir às tecnologias que prejudicam as pessoas historicamente marginalizadas fora das fronteiras da Big Tech e cooperar com defensores e organizadores externos para garantir isso.

Também precisamos de proteção e financiamento de pesquisas críticas fora do ambiente corporativo livre da influência das empresas. Nem toda empresa tem uma Goebra Timnit, pronta para resistir à censura da pesquisa. Pesquisadores fora do ambiente corporativo devem ter acesso mais amplo a tecnologias que estão atualmente ocultas por declarações sobre sigilo corporativo, por exemplo, acesso a conjuntos de dados educacionais, bem como políticas e procedimentos relacionados à anotação de dados e moderação do conteúdo. Esses espaços para pesquisas seguras e críticas também devem pagar prioridade ao apoio de Bipoc, mulheres e outros pesquisadores e perspectivas excluídos historicamente, reconhecendo que a homogeneidade racial e de gênero nessa área contribui para danos. Este trabalho exigirá financiamento significativo, que pode ser garantido pelo imposto cobrado dessas empresas.

Finalmente, a esfera da IA precisa desesperadamente regulamentação. As autoridades locais, estaduais e federais devem adotar leis que protejam a inviolabilidade da vida privada e garantam consentimento real para coletar dados e o uso da IA; Aumentar a proteção dos funcionários, incluindo a proteção de informantes e medidas para melhorar a proteção dos funcionários dentre pessoas sem estado e outras pessoas em discriminação; E também garantindo que aqueles que são mais vulneráveis antes dos riscos dos sistemas de IA possam desafiar e se recusar a us á-los.