Banco de dados de IA →

Todos, desde a ACLU até aos irmãos Koch, querem reduzir o número de pessoas que entram e saem da prisão. Os liberais veem o encarceramento em massa como um resultado injusto de um sistema racista. Os conservadores consideram o sistema de justiça criminal ineficaz e necessita urgentemente de reforma. Mas ambos os lados concordam: reduzir o número de pessoas atrás das grades é geralmente uma boa ideia.

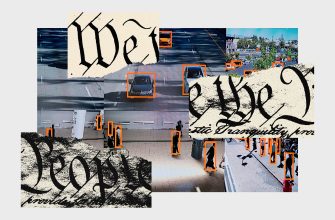

Para este efeito, a IA, em particular as chamadas tecnologias preditivas, está a ser utilizada para apoiar vários elementos do sistema de justiça criminal. Por exemplo, o policiamento preditivo utiliza dados sobre detenções anteriores e bairros para orientar os agentes para onde é provável que encontrem mais crimes, e sistemas semelhantes são utilizados para avaliar o risco de reincidência ao tomarem decisões sobre fiança, liberdade condicional e até mesmo sentenças. Os reformadores de todo o espectro político consideram as avaliações de risco algorítmicas mais objetivas do que a tomada de decisões individuais. Tomemos, por exemplo, a decisão de libertar uma pessoa da prisão enquanto se aguarda julgamento. Os defensores da avaliação de riscos argumentam que muito mais pessoas poderiam ser libertadas se os juízes tivessem acesso a ferramentas mais fiáveis e eficazes para avaliar o seu risco.

No entanto, uma investigação da ProPublica de 2016 descobriu que estas avaliações não só eram muitas vezes imprecisas, como também afectavam desproporcionalmente os arguidos afro-americanos, que tinham quase o dobro da probabilidade de serem classificados por algoritmos como de alto risco para crimes subsequentes ou violações das condições de liberdade condicional.

Usamos algoritmos como bolas de cristal para fazer previsões em nome da sociedade, quando deveríamos usá-los como um espelho para olharmos de forma mais crítica para nós mesmos e para os nossos sistemas sociais. A aprendizagem automática e a ciência de dados podem ajudar-nos a compreender e abordar melhor as causas profundas da pobreza e do crime, desde que não deixemos de utilizar estas ferramentas para automatizar a tomada de decisões e repetir injustiças históricas.

Problemas acadêmicos

A maioria dos AIS modernos exige uma enorme quantidade de dados para ensinar um carro para prever com mais precisão o futuro. Quando os sistemas são treinados para ajudar os médicos a identificar, digamos, o câncer de pele, as vantagens são óbvias. Mas, como uma ilustração terrível da importância dos dados usados para ensinar algoritmos, a equipe de Laboratório de Mídia provavelmente criou a primeira inteligência artificial de psicopata do mundo e a ensinou com a ajuda do infame Sabreddite, onde são publicados documentos sobre mortes alarmantes e violentas. Eles chamaram o algoritmo Norman e começaram a mostrar a ele as manchas de tinta de Rorshah. Eles também ensinaram o algoritmo em dados de origem mais benignos. O algoritmo padrão viu pássaros sentados em um galho de uma árvore, e o normando é um homem morto pela corrente.

Assim, quando a previsão de máquinas é usada para tomar decisões que afetam a vida de pessoas vulneráveis, arrisquemos danos àqueles que estão em uma posição desfavorável e transferem mais energia dos gerentes dos gerentes. Isso contradiz os princípios fundamentais da democracia.

Estados como Nova Jersey aceitaram o sistema de avaliação de risco pré-julgamento, na tentativa de minimizar ou abandonar completamente o uso de uma garantia em dinheiro, que, como numerosos estudos demonstraram, não é apenas ineficaz, mas geralmente é uma punição dura para Aqueles que não podem fazer isso pagam. Em muitos casos, a exigência de uma promessa monetária é na verdade um meio de detenção do acusado e privação de um dos direitos mais básicos: o direito à liberdade de acordo com a presunção de inocência.