O vídeo e o áudio sintéticos parecem muito ruins. A escrita sintética – onipresente e indetectável – será muito pior.

Assine o WIRED e fique atualizado com todas as suas ideias favoritas.

No mês passado, foi revelado o GPT-3, a próxima fronteira na escrita generativa: inteligência artificial capaz de criar frases que soam chocantes (embora às vezes surreais). À medida que se torna cada vez mais difícil distinguir o seu trabalho do texto gerado por humanos, é possível imaginar um futuro em que a grande maioria do conteúdo escrito que vemos online seja gerado por máquinas. Se isso acontecer, como mudará a nossa relação com o conteúdo que nos rodeia?

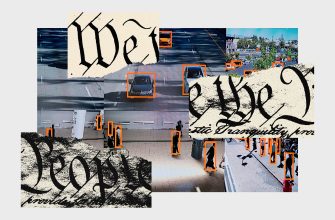

Este não é o primeiro ponto de inflexão nos meios de comunicação, quando as nossas ideias sobre a realidade mudam num instante. Quando o Photoshop, o After Effects e outras ferramentas de edição de imagens e CGI surgiram há três décadas, o seu potencial transformador para empreendimentos artísticos foi imediatamente reconhecido, assim como o seu impacto na forma como percebemos o mundo.“O Adobe Photoshop é sem dúvida o programa mais seminal da história da publicação”, dizia um artigo da Macworld de 2000 anunciando o lançamento do Photoshop 6. 0.”Hoje, os artistas dão os retoques finais ao fazer Photoshop em seus trabalhos, e os pornógrafos não teriam nada a oferecer além da realidade se não fizessem Photoshop em cada gráfico que produzem.”

Aceitamos a tecnologia como ela era e desenvolvemos um ceticismo saudável. Hoje, poucas pessoas acreditam que uma capa de revista retocada retrata uma modelo como ela realmente é.(Na verdade, muitas vezes é o conteúdo não-Photoshopado que chama a atenção do público.) Ainda assim, não acreditamos nessas fotos: embora haja debates acalorados ocasionais sobre o impacto da aerografia normalizada ou da filtragem mais relevante de hoje, nós ainda acredito que as fotos retratam uma pessoa real capturada em um momento específico. Entendemos que cada foto é baseada na realidade.

A mídia gerada, como um vídeo profundamente falsificada ou uma saída GP T-3, é completamente diferente. Com o uso malicioso, não há original inalterado, não há material de origem que possa ser usado como base para comparação ou evidência para verificar os fatos. No início dos anos 2000, foi fácil dissecar fotos de celebridades antes e depois e discutir se os últimos ideais irreais de perfeição criam. Em 2020, encontraremos mais e mais substituições plausíveis de celebridades em pornografia e vídeos, nos quais os líderes mundiais dizem algo que nunca dissemos antes. Teremos que nos adaptar e nos adaptar a um novo nível de irrealidade. Até as plataformas de mídia social reconhecem essa diferença: sua política de moderação de Deepfake distingue entre o conteúdo de mídia sintética e simplesmente “modificada”.

O texto gerado em todos os lugares distribuídos é capaz de deformar nosso ecossistema de comunicações sociais.

No entanto, para moderar conteúdo profundamente forjado, você precisa saber que é. De todas as formas existentes hoje, o vídeo pode ser o mais fácil de detectar. No vídeo criado pela inteligência artificial, muitas vezes existem pistas digitais, segundo as quais a imagem se enquadra no “vale sobrenatural”: “parâmetros biométricos suaves”, como movimentos de rosto humano, não são verdadeiros; Brincho ou vários dentes são mal desenhados; O batimento cardíaco humano, que pode ser determinado por mudanças de cores quase imperceptíveis, está ausente. Muitas dessas deficiências podem ser eliminadas usando configurações de software. Por exemplo, em vídeos falsos de 2018, a pisca de assuntos geralmente estava errada, mas logo após a publicação dessa abertura, o problema foi corrigido. O áudio gerado pode ser mais sutil – não há efeitos visuais, portanto, há menos possibilidades de erros – mas a pesquisa promissora está atualmente em andamento para lidar com isso. A guerra entre falsificações e autentistas continuará sem parar.

O mais importante é que o público esteja aprendendo cada vez mais sobre essa tecnologia. De fato, esse conhecimento pode ser o risco de um tipo diferente e, ao mesmo tempo Deepfake! “. Em um dos primeiros exemplos disso, que remonta ao final de 2017, os Surrotes Online mais apaixonados do presidente dos EUA sugeriram (após a eleição) que a gravação de Hollywood Access “Grab ‘EM” poderia ser gerada por um produto com um Voz sintética chamada Adobe voco.

Mas o texto sintético – especialmente o que está sendo criado agora – é uma linha mais complexa. Ele será facilmente gerado em grandes volumes e com menos sinais que permitem detectar. Em vez de usá-los em momentos responsáveis para criar uma mini-escandalagem ou uma “surpresa de outubro”, como no caso de vídeo ou áudio sintético, as falsificações de texto podem ser usadas massivamente para costurar um cobertor de mentiras perversas. Como qualquer pessoa que seguisse as hashtags quentes no Twitter pode confirmar, ativistas e profissionais de marketing igualmente percebem o valor do domínio, que é chamado de “parcela da voz”: vendo quantas pessoas expressam o mesmo ponto de vista, geralmente ao mesmo tempo no mesmo tempo no Na mesma hora ou no mesmo lugar, você pode convencer os observadores de que todos sentem de uma certa maneira, independentemente de essas pessoas serem realmente representativas – ou mesmo reais. Em psicologia, isso é chamado de ilusão da maioria. Como o tempo e os esforços necessários para criar comentários serão reduzidos, será possível criar uma enorme quantidade de conteúdo gerado pela IA em todos os tópicos que você possa imaginar. É possível que em breve os algoritmos leiam as páginas da web, formem “opiniões” e publiquem suas próprias respostas. Essa matriz ilimitada de novos conteúdos e comentários, amplamente criada por máquinas, pode ser processada por outras máquinas, o que levará ao surgimento de feedback, o que alterará significativamente nosso ecossistema de informações.

Teremos que nos adaptar e nos adaptar a um novo nível de irrealidade.

Agora você pode encontrar comentários repetidos ou reciclados que usam os mesmos fragmentos do texto para inundar a seção dos comentários, reproduzir a hashtag no Twitter ou convencer o público através das postagens no Facebook. Essa tática foi vista em várias campanhas manipulativas anteriores, inclusive em campanhas destinadas a chamar o governo dos EUA a comentários públicos sobre tópicos como empréstimos ao trabalho e a política de neutralidade da rede da FCC. A análise de alguns desses casos, conduzida pelo Wall Street Journal, revelou centenas de milhares de comentários suspeitos que foram definidos como tal, pois continham repetidas sentenças longas, que dificilmente eram espontaneamente compiladas por pessoas diferentes. Se esses comentários fossem gerados de forma independente, por exemplo, por inteligência artificial, essas campanhas de manipulação seriam muito mais difíceis de fumar.

No futuro, falsificações de vídeo e áudio poderão ser usadas para criar momentos sensacionais que tomarão conta de todo o ciclo da imprensa ou para desviar a atenção de outro escândalo mais orgânico. Mas as paródias sutis de texto disfarçadas de conversas comuns no Twitter, Facebook, Reddit e similares têm o potencial de ser muito mais sutis, muito mais difundidas e muito mais sinistras. A capacidade de gerar uma opinião majoritária ou criar uma corrida armamentista de falsos comentaristas com potencial mínimo de detecção permitirá campanhas de influência sofisticadas e em grande escala. O texto gerado ubíquo tem o potencial de distorcer o nosso ecossistema de comunicações sociais: o conteúdo gerado por algoritmos recebe respostas geradas por algoritmos, que alimentam sistemas de curadoria mediados por algoritmos que publicam informações com base no envolvimento.

A nossa confiança mútua está a enfraquecer e a polarização está a tornar-se mais comum. À medida que os meios sintéticos de todos os tipos – texto, vídeo, fotos e áudio – se tornam mais comuns e a sua deteção se torna mais difícil, será cada vez mais difícil confiarmos no conteúdo que vemos. Pode não ser tão fácil nos adaptarmos a isso como nos adaptamos ao Photoshop, usando a pressão social para limitar o uso dessas ferramentas e aceitando que a mídia que nos rodeia não é exatamente o que parece. Desta vez também teremos de aprender a ser consumidores mais críticos dos conteúdos online, julgando-os pelo seu mérito e não pela sua prevalência.

Fotografia: Jabin Botsford/The Washington Post/Getty Images