Passo o dia todo tomando decisões, e nem sempre são boas. Um algoritmo pode fazer um trabalho melhor ao decidir o que é melhor para mim?

Botão Reproduzir/Pausar

Pausa

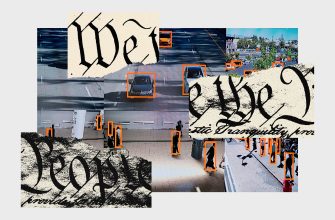

Vídeo: Equipe WIRED; Imagens Getty

Salve esta história

Salve esta história

Eu estava na metade do meu mestrado em ciência da computação quando minha visão mudou. Eu estava trabalhando como cientista de dados durante minhas férias de verão e tinha amigos que, em conversas normais, diziam coisas como: “Estou no máximo local”. Para onde quer que eu olhasse, a subotimização começou a se destacar, como erros de programação destacados em vermelho furioso.

Aqui estava um jovem de aparência atlética cujo passo lento bloqueava a trilha para que ninguém pudesse passar – abaixo do ideal. Havia um amigo com quem eu estava fazendo algumas tarefas que planejou as paradas em uma ordem ineficiente, de modo que a viagem demorou três músicas de Nicki Minaj a mais do que o necessário – abaixo do ideal. e então lá estava eu. Eu raramente conseguia dirigir por uma hora sem em algum momento ficar esquecido, distraído, cansado ou lento, o que era lamentavelmente abaixo do ideal.

Uma das primeiras coisas que aprendi sobre otimização foi que algo é ótimo se for igual ou preferível a qualquer alternativa. Otimizar a experiência, então, significa direcioná-la na direção daquilo que é preferido.

Tomar decisões geralmente é difícil porque você não sabe aonde cada escolha levará. No entanto, você tem dados sobre como suas ações se desenvolveram historicamente e, com a ajuda deles, pode adivinhar qual opção será mais preferível. Esta é a ideia básica do aprendizado por reforço subjacente à IA que pode aprender a jogar videogame e Go; outros problemas nesta área são conhecidos por nomes como “O inquieto bandido multi-armado”. Quando um agente informático faz uma escolha que leva a um resultado favorável através da aprendizagem por reforço, a memória de que a escolha foi “boa” influencia a tomada de decisão futura, reforçando o comportamento. Se um dia na vida também é uma série de decisões, um algoritmo também pode otimizar minha vida com sucesso?

A pergunta parecia simples, mas eu não conseguia parar de pensar nela. Finalmente me decidi: tentarei otimizar formalmente meu dia a dia. Num sábado, tomarei decisões usando um algoritmo que esbocei para escolher as melhores ações. Meu algoritmo foi uma tradução aproximada do Q-Learning – um dos algoritmos de aprendizagem por reforço mais simples – em etapas que um ser humano poderia seguir.

Funciona assim: quando tive que tomar uma decisão, primeiro a converti em um conjunto de ações entre as quais tive que escolher. Eu então decidiria qual escolher usando o gerador de números aleatórios do meu telefone. O RNG produziu um número entre 1 e 100. Se esse número fosse seis ou superior, escolhi a opção que historicamente produzia os resultados mais preferíveis. Um algoritmo de aprendizado por reforço ajuda a determinar quão preferível é uma opção com base nas observações anteriores do agente de computador. Eu aproximaria isso refletindo sobre os resultados de decisões semelhantes que tomei no passado.

Mais popular

A ciência

Uma bomba-relógio demográfica está prestes a atingir a indústria da carne bovina.

Matt Reynolds

Negócios

Dentro do complexo ultrassecreto de Mark Zuckerberg no Havaí

Guthrie Scrimgeour

Engrenagem

Primeiro, dê uma olhada no Matic, o aspirador robô redesenhado

Adriane So

Negócios

As novas alegações de Elon Musk sobre a morte de macacos estimulam novas demandas de investigação da SEC

Dhruv Mehrotra

No entanto, se o número aleatório resultante fosse cinco ou menos, eu “exploraria” e selecionaria a opção aleatória. Esta opção será selecionada gerando um segundo número aleatório. Por exemplo, para escolher uma opção aleatória entre cinco opções possíveis, eu dividiria os números de 1 a 100 em cinco grupos. O intervalo da primeira opção conteria números de 1 a 20, o intervalo da segunda opção conteria números de 21 a 40 e assim por diante. A opção escolhida será aquela em cujo balde está um novo número aleatório que eu jogo.

Com um ponto de corte de cinco, eu escolheria uma opção aleatória para aproximadamente cada vigésima decisão tomada pelo meu algoritmo. Escolhi cinco como ponto de corte porque parecia uma frequência razoável para seleção aleatória. Para aqueles que buscam o sucesso, existem processos de otimização adicionais que permitem decidir qual limite usar ou até mesmo alterar o valor de corte conforme você aprende. Na maioria das vezes, é melhor tentar vários valores e ver qual deles funciona melhor. Os algoritmos de aprendizagem por reforço às vezes executam ações aleatórias porque dependem de experiências anteriores. Escolher constantemente a melhor opção prevista pode fazer com que você perca uma opção melhor que ainda não experimentou.

Duvidei que esse algoritmo realmente melhoraria minha vida. Mas o esquema de otimização, apoiado por provas matemáticas, artigos revisados por pares e bilhões em receitas do Vale do Silício, fazia muito sentido para mim. Como exatamente isso pode desmoronar na prática?

Primeira decisão? Devo acordar às 8h30 como planejei? Desliguei o alarme, abri o RNG e prendi a respiração enquanto ele girava e cuspia… 9!

Agora a grande questão: no passado, dormir ou acordar na hora certa levava a melhores resultados? Minha intuição gritava que eu deveria pular todo o raciocínio e apenas dormir, mas para ser justo, tentei ignorar e contar minhas vagas lembranças do cochilo matinal. A alegria de estar na cama era maior do que uma manhã tranquila de fim de semana, decidi, desde que não perdesse nada importante.

Tive uma reunião de projeto em grupo pela manhã e, antes da reunião, tive que terminar de ler sobre aprendizado de máquina (“Aprendizado profundo bayesiano via inferência de sub-rede”, alguém?), então não consegui dormir por muito tempo. A RNG instruiu-me a decidir, com base na experiência anterior, se deveria faltar à reunião; Eu decidi ir em frente. Para decidir se deveria fazer a leitura, rolei novamente e tirei 5, o que significava que escolheria aleatoriamente entre ler ou pular.

Mais popular

A ciência

Uma bomba-relógio demográfica está prestes a atingir a indústria da carne bovina.

Matt Reynolds

Negócios

Dentro do complexo ultrassecreto de Mark Zuckerberg no Havaí

Guthrie Scrimgeour

Engrenagem

Primeiro, dê uma olhada no Matic, o aspirador robô redesenhado

Adriane So

Negócios

As novas alegações de Elon Musk sobre a morte de macacos estimulam novas demandas de investigação da SEC

Dhruv Mehrotra

Foi uma decisão tão pequena, mas fiquei surpreendentemente nervoso enquanto me preparava para jogar outro número aleatório no meu telefone. Se o resultado tivesse sido 50 ou menos, eu teria pulado a leitura para cumprir o componente “exploratório” do algoritmo de decisão, mas na verdade não queria fazer isso. Aparentemente, fugir da leitura só é divertido se você fizer isso de propósito.

Cliquei no botão GERAR.

65. Mesmo assim, vou ler.

Anotei uma lista de opções de como passar meu tempo livre. Eu poderia ir a um café distante que tenho vontade de visitar, ligar para casa, estudar, procurar programas de pós-graduação, navegar na Internet sobre um assunto não relacionado ou tirar uma soneca. Se o RNG apresentasse um número elevado, eu teria que tomar uma decisão sobre o que fazer com base nos dados.

Esta foi a primeira solução do dia é mais complicada que “sim” ou “não” e, assim que comecei a entender o quão “preferível” cada uma das opções é, ficou claro que eu não tive a oportunidade de faça uma avaliação precisa. Quando um agente da IA, o próximo algoritmo, como o meu, toma uma decisão, os cientistas da computação já lhe disseram o que considerar “preferível”. Eles traduzem o que o agente está enfrentando em uma avaliação da remuneração, que a IA está tentando maximizar, por exemplo, “o tempo gasto no videogame” ou “O dinheiro ganho no mercado de ações”. No entanto, determinar as funções da remuneração não é fácil. Um exemplo clássico é um robô intelectual. Se o robô for instruído a simplesmente maximizar a quantidade de detritos descartados, ele poderá aprender a girar a lixeira e jogar fora o mesmo lixo novamente para aumentar seu resultado.

Quanto mais eu pensava sobre qual das opções é preferível, mais me senti estranho. Como eu poderia converter o deleite do novo café com o conforto do sono ou alívio do progresso no trabalho em aplicações chatas? Parecia que esses resultados eram completamente incomparáveis. Qualquer avaliação de seu valor levará inevitavelmente ao colapso. No entanto, as próprias definições “ideais” e “preferidas” exigiram que eu as comparasse.

Não tive tempo de olhar em volta, já passei meia hora para pensar em opções. Qualquer métrica que eu imaginava para determinar a preferência era imperfeita. As decisões tomadas usando medições estão condenadas a realizar fatores que podem ser medidos: o salário é mais importante que a aut o-realização em uma carreira, a quantidade é mais importante que a qualidade da amizade. Infelizmente, os momentos mais ricos do ser humano que devemos a emoções que não podemos medir com precisão. Pelo menos por enquanto.