Se você acredita que os desenvolvedores dos sistemas de vigilância escolar, em breve as escolas do ensino fundamental e médio trabalharão com o princípio de um certo relatório de aglomeração de minorias, Pessoa de Interesse e Robocop. Os sistemas de classes militares coletarão dados sobre os alunos, capturando apenas uma pitada de pensamentos prejudiciais e enviarão policiais antes que os criminosos em potencial tenham tempo para executar suas ações vis. Se alguém puder ignorar os sistemas preditivos, ele inevitavelmente interromperá as armas de nova geração e os sensores biométricos que determinarão a marcha ou o tom de uma pessoa, impedindo as autoridades sobre o perigo que se aproxima. A última camada pode ser o tipo de drone mais avançado tecnologicamente–ou mesmo um homem de robô que pode neutralizar, distrair ou desativar uma pessoa perigosa antes que danos reais sejam causados. Se investirmos nesses sistemas, nossos filhos finalmente estarão seguros.

Se inscrever

Inscrev a-se na Wired e mantenh a-se a par de todas as suas idéias favoritas.

Este não é apenas o nosso presente, mas nunca será o nosso futuro – não importa quão vastos e complexos sistemas de vigilância se tornarão.

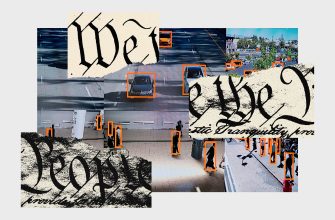

Nos últimos anos, muitas empresas apareceram que prometem várias intervenções tecnológicas para reduzir ou até eliminar o risco de execuções escolares. As “soluções” propostas variam de ferramentas usando aprendizado de máquina e monitoramento humano para prever o comportamento agressivo, a inteligência artificial em pares com câmeras que determinam as intenções das pessoas por sua linguagem corporal e microfones que determinam o potencial da violência pela votação. Muitos deles usam o fantasma de crianças mortas para anunciar suas tecnologias. Por exemplo, Anyvision, especializado em vigilância por vídeo, usa imagens de filmagem em Parckland e Sandy Gaok em apresentações de sua tecnologia para reconhecer rostos e armas de fogo. Imediatamente após a filmagem em UVold no mês passado, Axon anunciou planos de criar um drone equipado com um Stamper, como um meio de luta com as flechas da escola.(Mais tarde, a empresa suspendeu a implementação deste plano depois que os membros de seu conselho de ética deixaram o conselho). A lista pode ser continuada, e cada empresa gostaria que acreditassemos que a solução para esse problema pertence apenas a ela.

O fracasso aqui está não apenas nos próprios sistemas (em UVold, por exemplo, parece que pelo menos uma dessas “medidas de segurança” foi instalada), mas também na maneira como as pessoas os imaginam. Como no caso da polícia, cada falha do sistema de observação ou segurança geralmente leva ao fato de que as pessoas precisam de maior controle. Se o perigo não puder ser previsto e impedido, as empresas geralmente se referem à necessidade de obter dados adicionais para eliminar lacunas em seus sistemas, e governos e escolas geralmente concordam com isso. Em Nova York, apesar das numerosas falhas de mecanismos de vigilância por vídeo para impedir (ou mesmo capturar) uma flecha recente no metrô, o prefeito da cidade decidiu dobrar a necessidade de um número ainda maior de tecnologias de observação. Enquanto isso, as escolas da cidade supostamente ignoram a moratória da tecnologia de reconhecimento de pessoas. De acordo com o New York Times, apenas em 2021 as escolas americanas gastaram US $ 3, 1 bilhões em produtos e serviços de segurança. E o recentemente adotado pelo Congresso, a lei sobre armas inclui outros 300 milhões de dólares para melhorar a segurança escolar.

Muitos desses sistemas preditivos prometem um certo grau de confiança em situações em que não pode ser.

Mas, no centro próprio, muitos desses sistemas prognósticos prometem um certo grau de confiança em situações que não podem ser discutidas. As empresas tecnológicas estão constantemente promovendo a idéia de dados completos e, portanto, sistemas perfeitos, como algo localizado por trás da próxima crista – o ambiente em que somos tão totalmente observados que qualquer comportamento ant i-social pode ser previsto e, portanto, a violência pode ser evitada . Mas um conjunto abrangente de dados sobre o comportamento atual de uma pessoa é como um horizonte: pode ser conceitualmente representado, mas nunca alcançado.

Atualmente, as empresas usam vários métodos bizarros para ensinar esses sistemas: alguns são organizados por ataques de encenação, outros usam militantes como John Wick, que dificilmente são bons indicadores da vida real. Em algum momento, por mais lamentável que pareça, podemos assumir que essas empresas treinarão seus sistemas em dados obtidos durante tiroteios reais. Mas mesmo que o pessoal de incidentes reais esteja disponível (e em uma grande quantidade que esses sistemas são necessários), os modelos ainda não poderão prever com precisão a próxima tragédia com base nos anteriores. Walwade era diferente de Parkland, que era diferente de Sandy Hook, que era diferente de Columbine.

As tecnologias que se oferecem para prever intenções ou motivos fazem apostas estatísticas sobre a probabilidade de um determinado futuro com base em dados incompletos e sem contexto, independentemente da sua fonte. A suposição básica ao usar um modelo de aprendizado de máquina é que existe algum padrão que precisa ser identificado; neste caso, que existe algum comportamento “normal” que um atirador apresenta na cena do crime. Mas é improvável encontrar tal padrão. Isto é especialmente verdade dadas as mudanças quase contínuas no vocabulário e nas práticas dos adolescentes. Talvez mais do que muitos outros segmentos da população, os jovens mudam a forma como falam, vestem, escrevem e se apresentam – muitas vezes explicitamente, para evitar o escrutínio dos adultos e para se esconderem deles. É quase impossível criar um modelo consistentemente preciso de tal comportamento.