Banco de dados de AI →

Processando uma linguagem natural

Por duas décadas de trabalho no Vale do Silício, vi como o altruísmo eficaz (EA) – um movimento que consiste no número esmagador de homens brancos, baseado principalmente na Universidade de Oxford e no Vale do Silício, adquire um nível alarmante de influência.

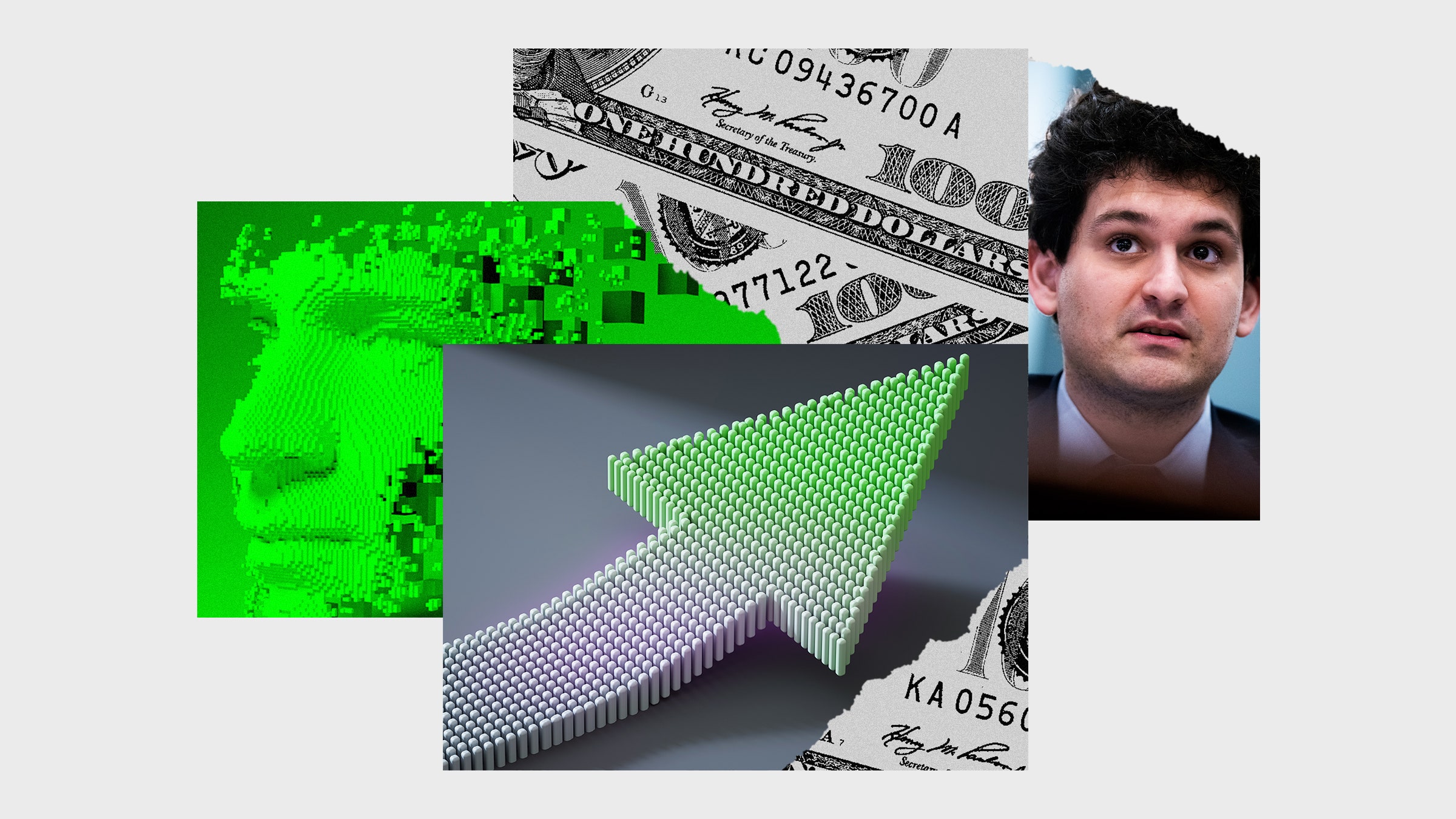

Atualmente, o EA é cuidadosamente estudado em conexão com o escândalo com a criptomoeda de Sam Bankman-Frida, mas eles escrevem menos sobre como essa ideologia agora determina a agenda da pesquisa no campo da inteligência artificial (AI), criando uma raça para a Espalhamento de sistemas nocivos, a ironia do destino, em nome de “Security AI”.

Se inscrever

Inscrev a-se na Wired e mantenh a-se a par de todas as suas idéias favoritas.

O Centro de Altruísmo eficaz define a EA como “um projeto intelectual que usa evidências e mente para entender como trazer o máximo benefício a outros”. E a “evidência e a mente” levaram muitos consultores à conclusão de que o problema mais urgente do mundo é a prevenção do apocalipse, quando uma criatura razoável (EDC) criada artificialmente pelas pessoas nos destruirá. Para evitar esse apocalipse, nas consultas de carreira na carreira da EA, “80. 000 horas”, já que duas das profissões mais recomendadas para consultores são “pesquisas técnicas da IA” e “Formação da administração futura da IA”, e a classe do milionário Os consultores financiam as iniciativas destinadas a prevenir uma AGI do Apocalipse. Segundo os consultores, a AGI é provavelmente inevitável, e seu objetivo é torn á-lo útil para a humanidade: é como criar um Deus amigável, não o diabo.

Entre os bilionários que alocaram fundos significativos para esses propósitos – Elon Musk, Vitalik Buterin, Ben, Jaan Tallinn, Peter Til, Dustin Muscovites e Sam Bankman – Fried, que foi um dos maiores patrocinadores da EA até a recente falência de sua criptomoeda FTX plataforma. Como resultado, todo esse dinheiro formou o campo da inteligência artificial e suas prioridades de tal maneira que prejudicam as pessoas de grupos marginais, ao mesmo tempo em que alegam trabalhar na “inteligência artificial útil de propósitos gerais”, que trará à humanidade techno-utopia. Este é outro exemplo do fato de que nosso futuro tecnológico não é um movimento linear em direção ao progresso, mas o que é determinado por aqueles que têm dinheiro e influência para control á-lo.

Um dos exemplos mais impressionantes da influência da EA é a Openai Company, fundada em 2015 por representantes da elite de silício, incluindo Elon Musk e Peter Tille, que alocaram US $ 1 bilhão para “garantir que a inteligência artificial beneficie toda a humanidade. “No site do Openai, observ a-se: “Tentaremos criar diretamente uma AGI segura e útil, mas também consideraremos nossa missão cumprida se nosso trabalho ajudar outras pessoas a alcançar esse resultado”. Til e Musk se apresentaram nas conferências da EA em 2013 e 2015, respectivamente. Elon Musk também descreveu o longtermismo, um ramo extremo da EA, como “correspondência estreita da minha filosofia”. Ambos os bilionários investiram fundos significativos em iniciativas semelhantes para criar “AGI útil”, como DeepMind e Miri.

Cinco anos após sua fundação, a Open IA lançou um grande modelo de idioma (LLM) sob o nome GPT-3 como parte de seu desejo de criar uma AGI “útil”. LLM é modelos treinados em enormes volumes de dados de texto para prever sequências de palavras prováveis. Este lançamento lançou as bases para a criação de modelos de idiomas cada vez mais maiores; Em 2021, Margaret Mitchell e outros colegas escreveram sobre os perigos desta corrida para o fundo do artigo revisado, o que levou à nossa demissão amplamente coberta do Google.

Mais popular

A ciência

Uma bomba demográfica de uma ação atrasada está prestes a atingir a indústria de carne

Matt Reynolds

Negócios

Dentro do complexo supe r-secreto Mark Zuckerberg no Havaí

Gatrine Skrimjor

Engrenagem

Primeira olhada em Matic, um aspirador de robô processado

Adrienne co

Negócios

Novas declarações de Elon Mask sobre a morte de um macaco estimulam novos requisitos para a investigação da SEC

Dhruv Mehrotra

Desde então, o desejo de aumentar o número de modelos de linguagem acelerou e muitos dos perigos sobre os quais alertamos, como a conclusão maciça de textos e desinformação odiados, continuam se manifestando. Apenas alguns dias atrás, a Meta lançou sua galáxia LLM, que pode supostamente “resumir artigos científicos, resolver problemas matemáticos, gerar artigos no wiki, escrever código científico, anotar moléculas e proteínas e muito mais”. Após apenas três dias, uma manifestação pública foi removida depois que os pesquisadores criaram “obras científicas e estatísticas de Vicky em uma variedade de tópico s-desde os benefícios do suicídio, comendo vidro esmagado e ant i-semitismo até o motivo pelo qual os homossexuais são maus”.

Esta corrida não parou no LLM, mas mudo u-se para os modelos de texto convertendo em uma imagem, como Dal l-e do OpenAI e modelos estáveis - modelos que levam o texto à entrada e fornecem imagens geradas com base neste texto. O perigo de tais modelos é criar pornografia infantil, perpetuar preconceitos, fortalecer estereótipos e distribuição em massa de desinformação, como muitos pesquisadores e jornalistas relatam. No entanto, em vez de desacelerar, as empresas removem as poucas funções de segurança que tinham, tentando superar uma à outra. Por exemplo, o OpenAI proibiu o upload de rostos gerados fotorrealistas nas redes sociais. Mas depois que as startups recé m-formadas como a Stabilityi, que supostamente atraíram US $ 101 milhões ao avaliar US $ 1 bilhão, chamados de medidas de segurança de “paternalistas”, o OpenAI removeu essas restrições.

Como os consultores baseiam instituições, empresas, centros analíticos e grupos de pesquisa em universidades de elite dedicadas à marca de segurança da IA, que é propagandizada pelo OpenAI, podemos ver ainda mais distribuição de modelos nocivos emitidos para um passo para o “AGI útil ”. E a influência começa cedo: os altruístas eficazes fornecem “subsídios para a criação de uma comunidade” para recrutar em grandes campi universitários, e os ramos da EA desenvolvem currículos e conduzem aulas de IA em universidades de elite como Stanford.

No ano passado, somente, antropia, que é descrita como uma empresa de segurança e pesquisa da IA e foi fundada por e x-vic e-presidentes do Openai em pesquisa e segurança, atraiu US $ 704 milhões, e a maior parte do financiamento veio da EA Billionaires como Talin, Maskovtsi E Bankman Fried. O próximo seminário sobre a “segurança da IA” na Neurips, uma das maiores e mais influentes conferências de treinamento em máquinas do mundo, também é anunciada como um FUGHT FUTURO DE FTX patrocinado, uma fundação de caridade orientada para a EA, cuja equipe saiu duas semanas atrás. O seminário anuncia US $ 100. 000 como um “prêmio de melhor relatório” – eu não vi essa quantia em nenhuma disciplina acadêmica.

As prioridades de pesquisa seguem o financiamento e, dado que grandes quantidades são investidas na IA em apoio à ideologia que possui adeptos de milionários, não é de surpreender que essa área esteja se movendo na direção prometendo o “futuro inimaginavelmente grande” em torno do ângulo e, ao mesmo tempo, espalha produtos, prejudiciais aos grupos marginalizados no presente.

Podemos criar um futuro tecnológico que nos sirva. Veja o caso da Te Hiku Media, que criou tecnologia de linguagem para revitalizar te reo Māori, criando uma licença de dados “baseada no princípio Māori de kaitiakitanga, ou tutela” para que quaisquer dados recebidos de Māori os servissem primeiro. Compare esta abordagem com a de organizações como a StabilityAI, que utilizam o trabalho de artistas sem o seu consentimento ou atribuição, ao mesmo tempo que afirmam criar “IA para pessoas”. Precisamos de libertar a nossa imaginação daquilo que nos foi vendido até agora: a salvação do hipotético apocalipse AGI imaginado por poucos privilegiados, ou da esquiva utopia tecnológica que nos foi prometida pela elite de Silicon Valley.