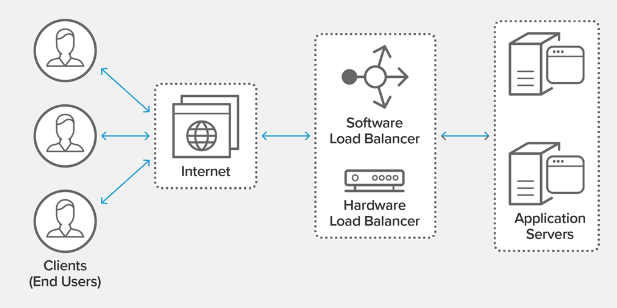

O balanceamento de carga do API Gateway é uma técnica que distribui com eficiência o tráfego de rede de entrada em vários endpoints de back-end, também conhecido como pool de servidores. Essa técnica é vital no cenário atual da Internet, onde um site típico processa milhares, senão milhões, de solicitações simultâneas de clientes.

Você pode otimizar o balanceamento de carga para integração de API usando diversas estratégias, incluindo monitoramento de desempenho, instalação de um balanceador de carga, armazenamento em cache de dados, escalonamento automático e escalonamento horizontal. Mas o que essas estratégias implicam? Este artigo aborda práticas recomendadas e dicas para balanceamento de carga e dimensionamento de um API Gateway privado ou de código aberto.

- Compreendendo a carga do API Gateway

- Latência

- Número de solicitações

- Códigos de status de erro

- Latência de integração

- Taxa de acertos do cache

- Estratégias para balanceamento de carga para o gateway da API

- Balanço de carga no menor número de compostos

- Balanceamento de carga no princípio de Round-Robin

- Balanceamento de carga concreta

- Balanceamento de carga por ip hesh

- Balanceamento de carga híbrida

- Estratégias de escala para o gateway da API

- Escala horizontal

- Escala vertical

- Escala automática

- Soluções em nuvem para equilibrar e escalar a carga do gateway da API

Compreendendo a carga do API Gateway

A carga do software de integração de API é a quantidade de tráfego de entrada em seus servidores back-end. Um balanceador de carga distribui esse tráfego por todos os servidores para garantir alto desempenho e velocidades de carregamento sem sobrecarregar nenhum deles. Além disso, o balanceamento de carga garante alta disponibilidade e confiabilidade, direcionando as solicitações dos clientes para servidores online.

As principais métricas a serem consideradas ao monitorar o desempenho de carga de APIs privadas ou gateways de código aberto incluem:

Latência

Latência é uma métrica que mede o tempo que leva para seu API Gateway processar e responder às solicitações do cliente. Quanto maior a latência, mais tempo poderá levar para você resolver problemas de desempenho com sua integração.

Número de solicitações

Monitorar o número de solicitações enviadas aos seus microsserviços de borda ajudará você a entender qual é a carga na sua API e o que você pode fazer para otimizá-la para lidar com o tráfego.

Códigos de status de erro

Um API Gateway totalmente funcional exibe códigos de erro 4XX e 5XX para falhas de cliente e servidor. Você pode monitorar a frequência desses códigos para identificar e resolver bugs em seus microsserviços de borda.

Latência de integração

Você pode monitorar a latência de suas integrações para identificar e solucionar problemas de microsserviços do API Gateway.

Taxa de acertos do cache

Se o seu gateway de API privado oferecer suporte ao cache de solicitações do cliente em um banco de dados secundário, o monitoramento das taxas de acertos do cache poderá ajudar a determinar se a carga no back-end está sendo reduzida conforme o esperado.

Mas como medir a eficácia destes indicadores? Aqui estão algumas ferramentas e técnicas populares para ajudá-lo a começar:

- Amazon CloudWatch: uma ferramenta de serviço em nuvem que monitora e notifica o excesso dos valores limite estabelecidos nos indicadores de atraso, o número de solicitações e a frequência de erro.

- Ferramentas de teste de estresse: as ferramentas modernas de teste de carga, como gatling, artilharia e jmeter apache, possibilitam simular a carga no tráfego e identificar mau funcionamento em um bloqueio de API privado.

- Raios-X da AWS: um serviço pago que permite aos clientes rastrear e depurar aplicativos distribuídos operando na infraestrutura da AWS. O serviço pode indicar você a erros que interferem no trabalho de seus serviços de microsserviços e AWS.

- Ferramentas de monitoramento de terceiros: ferramentas de monitoramento externas, como ApceDynamics, New Relic e Datadog, ajudarão você a rastrear e entender os indicadores de desempenho do desempenho da API-HLYU.

Estratégias para balanceamento de carga para o gateway da API

Os balanceadores de carregamento fornecem não apenas a segurança do gateway da API, mas também o roteamento de solicitações volumétricas de servidores distribuídos, aumentando o desempenho geral e a escalabilidade da integração. Tecnicamente, essa abordagem aumenta a disponibilidade de seus bancos de dados, aplicativos da Web ou quaisquer outros recursos de computação no bac k-end. Por sua vez, os clientes recebem experiência suave do usuário no fron t-end.

Estratégias comuns para balanceamento de carga para soluções integradas, como o Tyk Gateway, incluem o seguinte:

Balanço de carga no menor número de compostos

Essa estratégia eficaz para balanceamento de carga direciona o tráfego para servidores internos com o menor número de compostos. Isso garante que a carga vá para onde pode ser processada de maneira ideal.

Balanceamento de carga no princípio de Round-Robin

A estratégia Round-Robin fornece o roteamento do tráfego de entrada para servidores internos em uma determinada sequência. Essa abordagem distribui solicitações igualmente, garantindo que nenhum servidor seja sobrecarregado.

Balanceamento de carga concreta

Essa estratégia implica a apropriação de vários coeficientes de peso para servidores internos, dependendo de seu poder ou desempenho, garantindo que um tráfego mais recebido seja direcionado para servidores mais poderosos.

Balanceamento de carga por ip hesh

Como o nome indica, essa estratégia usa o endereço IP do cliente para garantir que as solicitações do usuário sejam sempre enviadas ao servidor interno desejado para sessões de cliente sem obstáculos.

Balanceamento de carga híbrida

Uma abordagem híbrida envolve a implantação de vários algoritmos para balanceamento de carga para aumentar o desempenho e a confiabilidade. Por exemplo, você pode usar o balanceamento da carga de hash IP para otimizar grandes cargas e equilibrar a carga de carga-robina para equilibrar sessões com sessões de tráfego baixo.

Estratégias de escala para o gateway da API

A escala significa a otimização da integração do seu API-HLYU e sua integração com recursos adicionais, como servidores ou instâncias, para expandir seus recursos para processar um maior tráfego e demanda por acessibilidade. A escala dos recursos do gateway de código aberto fornece várias vantagens para os negócios, incluindo:

- Maior desempenho: a distribuição do tráfego recebido entre várias cópias ou servidores, que fornece uma carga mais baixa em cada uma delas para respostas mais rápidas.

- Maior disponibilidade: a integração de mais recursos com seus Serviços Micr o-Border garante que o sistema possa processar um tráfego mais recebido sem tempo de inatividade.

- Flexibilidade e flexibilidade: otimização dos recursos de computação, adicionando ou removend o-os conforme necessário, aumenta a flexibilidade e a flexibilidade da organização, permitindo que ela se adapte às mudanças nas condições de demanda.

- Otimização dos custos: a escala pode ajudar a otimizar os custos totais do gateway da API, permitindo que você realize as funções do processamento de um grande volume de tráfego sem investimentos em novos equipamentos ou infraestrutura de TI.

Dadas essas vantagens, essas são algumas estratégias que ajudarão você a satisfazer a necessidade de escalar microsserviços:

Escala horizontal

Essa estratégia implica a integração de seus microsserviços de limite com servidores ou amostras adicionais para aumentar a energia, especialmente se as necessidades do cliente não puderem ser satisfeitas usando um servidor ou cópia.

Escala vertical

A escala vertical é uma estratégia ideal que permite otimizar a potência de uma cópia ou servidor para processar o tráfego com alta demanda, especialmente se você não precisar de recursos adicionais do servidor.

Escala automática

Como o nome indica, essa estratégia usa critérios predeterminados para adicionar ou remover automaticamente os recursos de computação do sistema de acordo com a demanda anterior. Esta é a melhor opção se você deseja reduzir custos.

Soluções em nuvem para equilibrar e escalar a carga do gateway da API

Além dessas estratégias, o diretor técnico pode usar soluções em nuvem para dimensionar os domínios do usuário das API-Shules. Diferentemente de outras soluções, como monitoramento, as opções de escala de nuvem são inerentemente seguras e equipadas com várias funções cibe r-protetivas, como firewalls e criptografia para proteger sua integração contra hackers.

Além disso, as soluções em nuvem para escala são mais acessíveis e a facilidade de uso em comparação com seus análogos locais. Entre os exemplos comuns de tais soluções, podem ser chamados do seguinte:

- Amazon API Gateway: um serviço de TI controlado, oferecendo funções internas de escala e balanceamento para otimizar seu sistema para aumentar o trabalho e o desempenho sem problemas.

- TYK: Uma solução em nuvem totalmente controlada para gerenciar a API, poderosa, flexível e altamente programada, permitindo que os desenvolvedores sejam fáceis de criar, proteger, publicar e manter APIs em qualquer escala e em qualquer lugar do mundo.

- Os pontos finais do Google Cloud: outro serviço controlado de TI que permite aos clientes criar e implantar microsserviços na nuvem. Ele vem com funções construídas de balanceamento e escala automática.

- Gerenciamento da API do Microsoft Azure: um serviço controlado da Amazon, que permite aos usuários otimizar seus microsserviços regionais usando funções de Buil t-in de escala de escala e cargas de balanceamento para o processamento de um grande tráfego de entrada.

- Kong: API Cloud com código aberto, que também construiu funções –in de escala automática e balanceamento de carga para implantar integrações de alto desempenho.

Veja como introduzir uma solução em nuvem para integrar a API:

- Selecione um fornecedor autoritário de serviços em nuvem

- Crie um protocolos de autenticação ou autorização da API e determinar.

- Configurar as funções da escala e equilíbrio da carga

- Configurar os políticos funcionais como necessário para obter o desempenho ideal

- Teste e expanda a solução na produção

A estratégia de balanceamento de carga listada neste guia, como IP Hesh, Round-Robin e Hybrid, ajudará você a otimizar a operação do gateway da API para aumentar a disponibilidade e acelerar as respostas às solicitações do usuário. Da mesma forma, você pode executar uma escala vertical, horizontal ou automática para aumentar o desempenho.