A moderação de conteúdo está consumindo o mundo. Os conjuntos de regras das plataformas estão a expandir-se, os seus serviços estão cheios de atalhos e dezenas de milhares de utilizadores são removidos regularmente. Nenhuma plataforma está imune às exigências de intervir e colocar barreiras ao conteúdo gerado pelo usuário. Esta tendência não é nova, mas as circunstâncias únicas da emergência de saúde pública global e a pressão em torno das eleições de 2020 nos EUA levaram à sua intensificação. Agora, à medida que partes do mundo começam a emergir da pandemia e os principais trolls da Internet se retiram para um blog pouco visitado, surge a questão de saber se o ano passado foi o início de uma descida na temida ladeira escorregadia da moderação de conteúdo, ou se é uma condição excepcional que terminará.

É claro que os velhos tempos nunca mais regressarão, quando plataformas como o Facebook e o Twitter tentavam eliminar a maior parte do que acontecia nos seus sites, confiando que os utilizadores da Internet, enquanto comunidade global, se governariam a si próprios. Mas avançar lenta e firmemente em direção a um futuro em que mais problemas serão resolvidos através da eliminação de conteúdos da Internet é uma abordagem simplista e ineficaz para questões complexas. A Internet está numa encruzilhada e precisamos de estar atentos ao caminho que tomamos para chegar a ela. Mais moderação de conteúdo nem sempre é melhor e há compensações a cada passo. Essas compensações podem valer a pena, mas ignorá-las não significa que não existam.

Uma análise de como chegamos até aqui mostra que as soluções para os problemas das redes sociais não são tão óbvias quanto podem parecer. A desinformação pandêmica deveria ter sido fácil. Em resposta à emergência global, as plataformas estão finalmente a agir rapidamente para impedir a desinformação sobre a Covid-19 como nunca antes. Como resultado, houve cerca de uma semana em Março de 2020 em que as plataformas de redes sociais, que tinham sido alvo de críticas quase implacáveis nos últimos quatro anos, voltaram a funcionar.”Quem poderia imaginar que o techslash era suscetível a um vírus?”- perguntou Steven Levy. perguntou Steven Levy.

Estas ações despertaram tanto entusiasmo que houve apelos imediatos para que se fizesse o mesmo com toda a desinformação – e não apenas com a desinformação médica. As plataformas inicialmente insistiram que a desinformação da Covid era outra coisa. Era mais provável que causasse danos, argumentaram. Além disso, existem autoridades claras a quem podem recorrer, como a Organização Mundial de Saúde, que lhes podem dizer o que é certo e o que é errado.

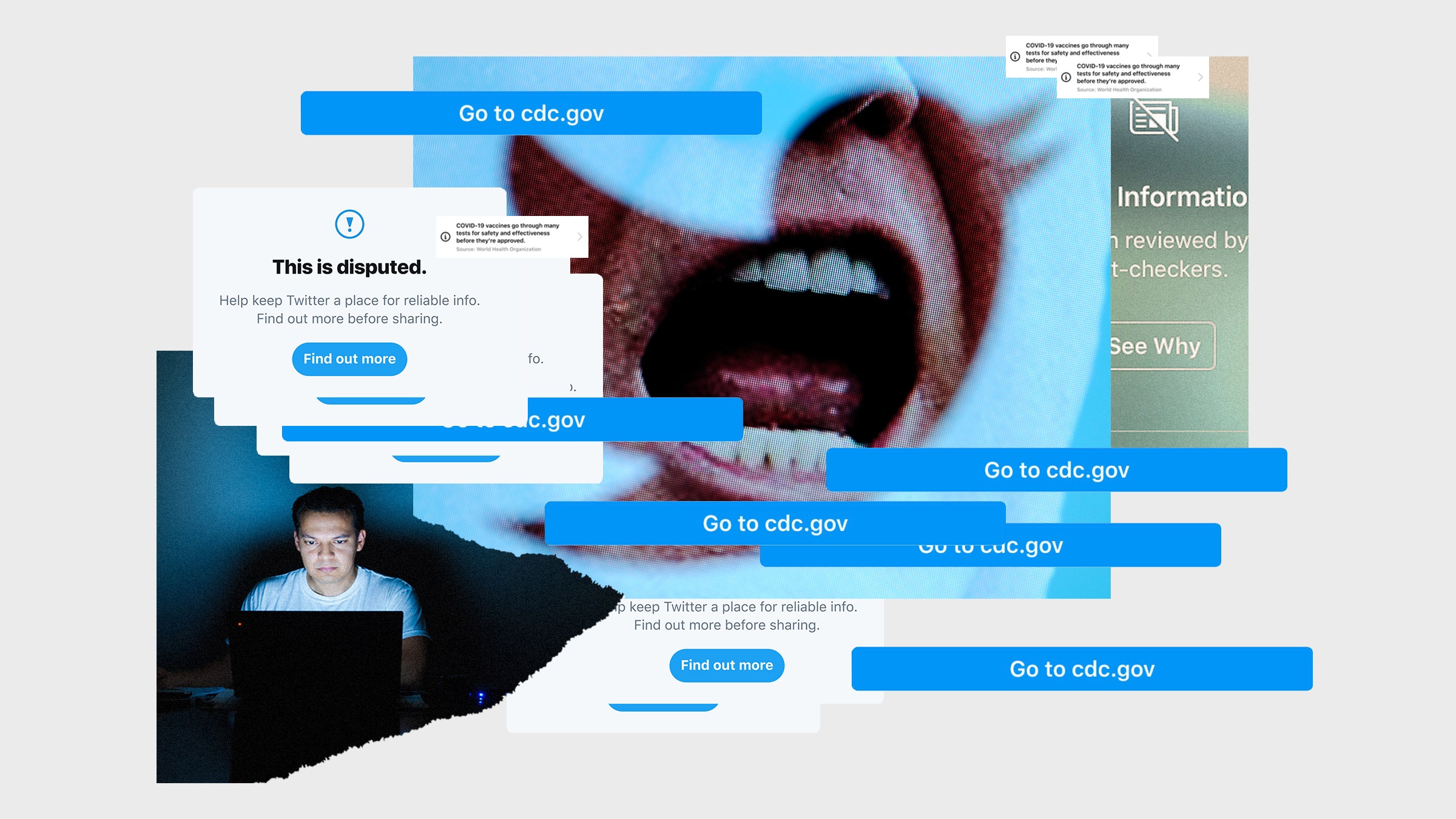

Mas esta linha não durou muito. As plataformas continuaram a impor cada vez mais restrições ao que as pessoas podiam dizer sobre os seus serviços. Durante as eleições de 2020 nos EUA, eles espalharam rótulos por toda parte. Eles agiram com extraordinária velocidade para rebaixar ou bloquear um importante meio de comunicação, o New York Post, sobre a história de Hunter Biden. Eles deplataformaram os negadores do Holocausto, os crentes do QAnon e, em última análise, o próprio presidente em exercício dos Estados Unidos.

A moderação de conteúdo cresceu como uma bola de neve e os danos colaterais ao longo do caminho são frequentemente ignorados.

Para muitos, tudo isso não foi suficiente. Os apelos para que as plataformas façam melhor e removam mais conteúdo permanecem fortes e constantes. Os legisladores de todo o mundo não estão certamente a diminuir a pressão. Dificilmente existe um país no mundo que não esteja a tomar medidas para regular as redes sociais de uma forma ou de outra. Na semana passada, a União Europeia melhorou o seu Código de Prática sobre Desinformação, afirmando que é necessário um código mais forte porque “as ameaças representadas pela desinformação online estão a evoluir rapidamente” e que a infodemia em curso está “colocando em risco a vida das pessoas”. Os senadores dos EUA ainda escrevem cartas às plataformas pedindo-lhes que removam perfis específicos. As plataformas continuam a implementar novas regras destinadas a conter a propagação de desinformação.

À medida que as empresas desenvolvem cada vez mais novos tipos de tecnologia para pesquisar e remover conteúdo de diferentes maneiras, existe a expectativa de que elas devam utilizá-la. A capacidade de moderar implica a necessidade de moderação. Afinal, uma vez utilizada uma ferramenta, é difícil colocá-la de volta na caixa. Mas a moderação de conteúdo está crescendo como uma bola de neve e os danos colaterais ao longo do caminho são frequentemente ignorados.

Agora é a oportunidade de considerar cuidadosamente seus próximos passos. Com as contas de Trump nas redes sociais e a eleição no espelho retrovisor, a moderação de conteúdo não é mais um tema recorrente na A1. Talvez isto prove que a política, e não as plataformas, foi na verdade a causa de toda esta agitação. Mas há – ou deveria haver – alguma preocupação persistente sobre a impressionante demonstração de poder que um punhado de executivos empresariais demonstraram ao desativar as contas do líder do mundo livre.